摘要

电子游戏中的非玩家角色(NPC)a与现实生活中的动物之间的区别是程度上的而非本质上的。NPC和动物本质上都是从一系列简单的物理操作中产生的主体,NPC和动物之间的主要区别在于认知和情感复杂性。因此,如果我们非常关心动物,我们可能会稍微关心游戏NPC,至少是那些更复杂的版本。我认为即使是现在的NPC总体上也有一些道德意义,尽管它们在我们当前世界的道德问题中并不排在前列。然而,随着NPC的复杂性和数量的增加,我们对电子游戏角色的道德义务可能会成为一个紧迫的道德话题。

注意:本文并不是要论证电子游戏角色一定比其他计算机程序或甚至其他非NPC游戏元素更值得道德关注。相反,我的目的只是通过关注游戏NPC这个有趣而熟悉的例子,来探讨在简单系统中看到微小程度的意识这一一般性想法。关于软件中意识的更一般性讨论,请参见"什么是痛苦子程序?"

本文的其他版本:

- 音频播客(.mp3)

目录

引言

电子游戏给社会带来了一些道德问题。可能争议最激烈的是血腥电子游戏是否会影响现实世界的暴力倾向。一些研究发现电子游戏与暴力之间没有因果关系,而其他研究(包括实验操作)确实表明存在某种导致现实世界攻击性的因果途径(参见维基百科的文章了解更多)。我的主观经验与"脱敏"假说一致,尽管有些人可能会反过来争辩说,电子游戏允许以无害的方式释放攻击性。

另一个有时提出的道德问题是电子游戏的成瘾潜力,这可能会降低学习或工作表现,损害人际关系等。一些人还担心电子游戏比书籍更容易麻木头脑,会抑制青少年的智力发展。其他人则指出,电子游戏是一种可能相当复杂和具有挑战性的艺术形式,像《魔兽世界》这样的大型多人在线角色扮演游戏甚至可能教会玩家规划、团队合作和领导力。

这些话题值得探讨,但它们不是我在这里关注的重点。在这篇文章中,我提出了一个不太常见的问题:电子游戏中的角色在道德上是否重要,不仅仅是出于工具性原因,而是为了他们自身?我不知道我是否听过有人提出这个问题,至少对于现在的电子游戏来说是这样。大多数人会认为这是荒谬的。但我认为在进一步审视后,答案并不那么明显。

虚构与现实

儿童在3-5岁左右学会区分虚构和现实(参考)。上下文有助于确定这种区别。例如,在《罗杰斯先生的邻居》中,节目中的真实角色生活在外部世界,而虚构角色则生活在明确分开的"虚构邻居"中。儿童学会他们的家人、朋友、国家领导人和科学事实是现实的一部分,而小说书籍、电影和电子游戏是虚构的。如果虚构角色受伤是可以的,因为他们实际上并不存在。当孩子看到电影中的角色受伤倒下时,父母可以安慰孩子,解释说屏幕上的人只是演员,血是假的。同样,电子游戏中的暴力显然不是真实的,因此除非它导致现实世界中的反社会行为,否则并不重要。

但是我们说某事是"真实的"是什么意思呢?我们的真实世界,由汽车、家庭、爱情和未来计划组成,是将微小的物理粒子排列成越来越高层次的抽象:从原子到分子到蛋白质到细胞到器官到人,它们在社会中相互作用。我们是由大量愚蠢的、基本的物理操作构建而成的极其精巧的机器,这些操作以形成美丽动态和有意义的方式组合在一起。"现实"由我们用来理解这些复杂粒子运动的所有更高层次的抽象组成。这些抽象对我们来说很重要,决定了我们是快乐还是沮丧,充满希望还是恐惧。一些神经科学研究表明,我们对什么是真实的感觉是由它的相关性和与我们的个人联系程度决定的。

现在考虑一个复杂、智能的电子游戏角色。它也是由微小的物理物质构建而成的抽象层:电子和原子、晶体管、逻辑门、计算机硬件,使用二进制代码运行,这些代码是从更高级的代码创建的,而这些代码本身又以模块化的方式组织,从单个语句到函数到类到软件包,所有这些都在可以在计算机网络中交互的计算机内。

我们可以说,"计算机角色不是'真实的',因为它只是一系列愚蠢的物理操作的集合,每个操作都非常简单和无感觉。"但我们也是由愚蠢的、"无感觉的"物理操作构建而成的。构成电子游戏角色"大脑"的晶体管与构成你大脑的神经元一样"真实";在这两种情况下,我们甚至可以指出涉及的物质团块。

"好吧,"有人可能会承认。"这个角色的大脑和我的一样真实,但它的世界是假的。我与真实的物理世界互动,而这个角色则与幻想的物理世界互动。"但真的有这么大的区别吗?你世界中的树木、岩石和墙壁是基本粒子以复杂的聚集方式行为的集群。例如,你椅子中的原子以一种能够自我维持的方式行动。电子游戏角色也与由基本物理粒子组成的对象(例如晶体管中的原子和电子)互动,这些粒子以特定方式行为来定义它们的行为。这些粒子在两种情况下的行为是不同的,但正在发生的事情的类型是相似的。

如果有帮助的话,我们可以想象《塞尔达传说》游戏中的地牢墙壁是实际的物理墙壁,定义主角林克的原子在试图移动到墙壁中时会撞到这些墙壁。计算机中的这些墙壁在空间上并不是以与游戏中相同的配置排列,但它们在游戏中是逻辑上以该配置排列的,根据从原子/电子到虚拟墙壁的复杂数学映射。(这个映射是什么?它由游戏的代码定义。)同样,我们经历的建筑物墙壁本身就是现实基本元素的复杂映射。我们不会经历量子力学中多世界的退相干,也不会经历M理论中除3个空间维度和1个时间维度之外的7个额外维度。正如Donald D. Hoffman在"感知的界面理论"中指出的那样:"就像PC界面的图标隐藏了计算机的复杂性一样,我们的感知也有用地隐藏了世界的复杂性,并引导适应性行为。"游戏角色的感知同样适当地与其世界的逻辑边界相互作用。

"真实"的实体是从低级物理粒子相互作用中产生的模式,有意义的模式可以在微处理器内部电流和电压的变化以及生物体内生物分子的配置中看到。

这个讨论更深入地探讨了我在本节中的主要观点。

目标导向行为和意识

如果电子游戏可以被视为与我们自己的世界类似的"真实",那么电子游戏角色与真实的人和动物有什么区别呢?我认为这归结为复杂性的差异,特别是与我们认为与"意识"相关的特定算法有关。正如我在其他地方所论证的,意识不是一个二元属性,而是可以在各种系统中以不同程度的清晰度看到。我们可以将电子游戏角色解释为具有最基本的意识雏形,例如当它们反思自己的状态变量("自我意识")、报告状态变量以在程序的其他部分做出决策("信息广播")以及在可能的行动中选择以最好地实现目标("想象、规划和决策")时。诚然,这些程序比动物中发生的要简单得多,但一个模糊的轮廓是存在的。如果人类的意识是一块巨石,那么现在的电子游戏角色可能是一粒沙子。

使用生物学上合理的认知算法的数字代理似乎最有可能值得道德考虑。如果它们使用强化学习,有一种表示不同经历的正面和负面价值的方式,并以一种将大脑不同部分统一为有意识集体的方式广播这些信息,那就更是如此。然而,我认为生物体的其他属性至少也有一点重要,比如表现出明显的目标导向行为,有一个衡量其状况"更好还是更糟"的标准,并根据环境情况执行复杂的操作。许多电子游戏中的NPC至少在一定程度上具有这些属性,即使大多数(幸运的是)还没有强化学习或复杂情感的框架。

许多NPC表现出目标导向行为,即使这只意味着实现寻路算法或选择面对游戏主角的方向。

考虑一个真实电子游戏的例子:毁灭战士3 BFG版(源代码)。在AI.cpp文件中,我们可以看到AI如何实现KickObstacles、FaceEnemy、MoveToEnemyHeight、MoveToAttackPosition等功能。当然,这些功能与真实动物从事行动时发生的情况相比非常简单。但区别在于复杂性,是程度而非种类的区别。真实动物踢障碍物、面对敌人等行为涉及更多步骤、身体部位和高级系统,但从根本上说,它们是由我们在这里看到的相同类型的组件构建的。

特别是在角色扮演游戏中,一些NPC有明确的"福利水平"表示,形式为生命值(HP),NPC至少实施粗略的基于规则的行动,旨在保护他们的HP。在一些回合制角色扮演游戏中,如《超级马里奥RPG》或《宝可梦》,NPC甚至可能选择一个唯一目的是在战斗后续回合中增强其防御能力的行动。伤害程度可能会影响行动选择。例如,在《泰坦的复仇》(源代码)中,无人机根据包含HP伤害的评分公式选择目标建筑:

rating = cost * (damage / newTarget.getMaxHitPoints()) * factor * distanceModifier;

即使没有明确HP水平的NPC也有隐含的福利程度,比如是否被杀死的二元标志。需要多次打击才能被杀死的NPC - 例如,需要用剑击打三次才能死亡的boss - 携带未向用户公开的HP状态信息。他们还会在受到伤害时显示脚本化的厌恶反应。

也许价值表示可以比明确的数字(如HP)更抽象地看待。在动物大脑中,价值似乎是由某些神经网络输出节点的发射模式编码的。为什么我们不能也说NPC中状态变量的模式编码了它的价值呢?动物的刺激价值存在是因为这种价值操作对大脑其他部分的连锁效应。那么为什么不把NPC中触发连锁效应的变量或算法视为至少是一种隐含的价值呢?

意识和权力

对这篇文章的一个反复出现的批评是观察到NPC没有复杂的自我监控功能,这种功能会给他们真正的"有意识"体验,而不是"在黑暗中"度过生活。我承认这个抱怨是相关的,也许经过进一步检查,我会同意NPC并不那么重要,因为他们的自我反思通常没有很好地完善。但我们应该考虑一下我们的观点是否稳健,即自我监控特别是情感体验的关键特征。

在"感觉整合了情绪中评估驱动的反应组织的中心表征"中,Klaus R. Scherer提出了情绪的五个不同组成部分(这个表格是从文本第138页的表9.1复制的):

CNS = 中枢神经系统; NES = 神经内分泌系统;

ANS = 自主神经系统; SNS = 体神经系统

| 情绪功能 | 有机体子系统和主要基质 | 情绪组成部分 |

| 对物体和事件的评估 | 信息处理(CNS) | 认知组成部分 |

| 系统调节 | 支持(CNS; NES; ANS) | 神经生理组成部分 |

| 行动的准备和方向 | 执行(CNS) | 动机组成部分 |

| 反应和行为意图的交流 | 行动(SNS) | 运动表达组成部分 |

| 内部状态和有机体-环境互动的监控 | 监控(CNS) | 主观感受组成部分 |

我们可以看到,情绪是一个复杂的过程,有许多部分在起作用。那么为什么我们要特别重视主观感受组成部分,认为只有它才重要呢?一个原因可能是它可能是系统中最核心的特征。在Scherer的观点中,监控过程有助于协调和组织其他系统。但是特别重视它似乎类似于建议在一个员工团队中,只有管理和监督他人工作的领导者才有意义,而工人本身是无关紧要的。b无论如何,根据我们如何定义监控和协调,这些过程可能发生在许多层面上,就像公司管理金字塔有许多层一样。

Daniel Dennett的《意识解释》是挑战将"无意识"与"有意识"处理分开的观点的经典文本之一。他说(第275页):"我坚持认为,没有动机去划一条线,将肯定'在'意识中的事件与永远'在外'或'在下'意识的事件分开。"

我认为人们如此强调监控组成部分的原因是,它是系统中执行抽象分析和语言认知的大脑中心可以看到的部分。当我们内省时,我们使用自我监控装置进行内省,所以自然而然地,这就是我们说对我们重要的东西。我们的内省看不到的东西,我们就不会明确关心。但是为什么如果我们从神经科学知道它们存在,我们就不能关心子系统呢,即使我们无法通过内省识别它们?直觉上我们可能不喜欢这个建议,因为我们倾向于不关心我们无法直接感受到的东西;"眼不见,心不烦"。但如果我们对情况采取更抽象的看法,就不那么清楚为什么监控如此重要了。为什么我们不能也关心一群没有管理者/报告者的工人呢?

我对意识的高阶理论持怀疑态度。我认为人们采用这些观点可能是因为当他们思考自己的情绪时,当然在那一刻他们对低阶心理状态有更高阶的感知/思考。但这并不意味着意识总是一个高阶现象,即使在你不看的时候也是如此。诚然,我认为主观体验的一个重要元素来自监控,元认知可能对意识的质地有所贡献,但我对监控是意识的全部的断言持怀疑态度。毕竟,是什么让这些计算与其他计算相比特别呢?人们可以说所谓的一阶感知实际上是对世界中一阶对象的二阶感知。

关注监控和可报告性而不是"无意识"子组件似乎是一个权力问题。我们思考道德问题的那些部分倾向于关心监控功能,这与美国总统得到媒体所有关注的方式类似,尽管是他的下属做了大部分工作。如果有人问自己是否意识到低级过程,他会想"不,我没有"。然而,正如盲视、潜意识刺激和各种其他"无意识"现象所表明的那样,我们通过明确内省无法发现的效果仍然有影响,并且隐含地对我们很重要。

所谓"有意识"(全局可用)信息与"无意识"信息的一个不同之处在于,我们可以无限期地保留有意识的信息,正如Stanislas Dehaene在《意识与大脑》中解释的那样。我们的头脑有Daniel Dennett所说的"回声室",允许内容被思考和重新思考,并保留下来以供检查和元认知。无意识信息来了又去,没有留下太多持久的痕迹。这有助于解释为什么我们只能谈论有意识的数据。但是只有有意识的数据重要吗?它最终也会消失(除非它进入长期记忆,即使这样我们最终也会死亡)。相关性不应该根据某事对系统的影响程度来评估,而不是它是否可以被报告的二元事实吗?

考虑一个裂脑患者。当只向她的右半球呈现一个物体时,她说她看不到它;这是因为语言区集中在左半球。但她仍然可以用右半球控制的手去拿那个物体。认为只有大脑的左半部分是有意识的,仅仅因为只有它能做出语言报告,这似乎是不合理的。

一旦我们可以在计算机大脑模型中大致看到情感子系统是如何运作的,我们是否倾向于给予那些无声的子组件更多权力,还是我们想继续偏爱我们的本能倾向于关心的有意识监控部分?我对此没有确定的看法,但我认为我们不应该跳到结论,认为只有监控器很重要。这个问题在非意识组件与有意识总结不一致或根本没有报告的情况下尤其相关。对于像NPC这样可能只有相对于所谓"无意识"计算量而言的基本监控的代理来说,这也是相关的。

无论如何,NPC确实有对其内部状态的极其粗糙的监控器,比如生命值的显示或它们发出的口头感叹(例如,尖叫)。我们可以看到上表中情绪的其他组成部分也以基本的方式在NPC中表现出来。

丹尼特的立场层次

NPC在复杂程度上有所不同。例如,考虑Al Sweigart的"用Python和Pygame制作游戏"第8章中的游戏"松鼠吃松鼠"。这个游戏的程序非常简单 - 不算从Pygame导入的内容,只有396行代码。各种大小的松鼠从不同方向走到屏幕上。如果它们比主角松鼠小,主角就会吃掉它们;否则,它们会伤害主角。它们可能偶尔随机改变方向,但这就是它们所做的全部。它们不规划路线,不寻求避免伤害,甚至不试图面对主角。它们只是随机移动,如果它们撞到主角,要么被吃掉,要么造成伤害。

这个游戏中的NPC松鼠可以用Daniel Dennett所说的"物理立场"来充分描述:行为类似于粒子移动或其他粗糙的物理过程。(这些是"愚蠢的粒子更新",所有更高层次的立场都作为涌现现象出现。)例如,松鼠游戏可以被看作类似于太空中的行星。如果像地球这样的大行星撞上一个小行星,小行星就会被吸收,使地球变得稍微更大。如果地球撞上比自己更大的行星,它就会被炸碎并受损。我们可以想到很多其他的物理类比,比如水滴聚集在一起。

在《超级马里奥兄弟》中,栗宝和乌龟可以纯粹用物理立场来看待,因为它们只是朝一个方向走,直到撞到障碍物,然后就朝相反方向走。一个弹跳的球是可比较的(事实上,由于加速度、摩擦等原因,可能更复杂一些)。

游戏中非动物类的环境特征可以被视为具有可比较的复杂性,例如《水晶洞穴》中危险的水滴或落石。《水晶洞穴》的每个关卡还有一个空气站,如果游戏主角不小心射击它,它就会爆炸。这个空气站的行为并不比最基本的游戏敌人简单多少(毕竟,空气站如果被射击就会"死亡",尽管它不会四处移动或对主角造成伤害),但它可以完全用物理立场来建模。

其他NPC稍微复杂一些。例如,《超级马里奥兄弟》中的锤子兄弟会转身面对马里奥,如果马里奥等待足够长的时间,它们就会开始追赶马里奥。这种行为可能更接近"意图立场"的水平(它们对马里奥的位置有信念,它们有用锤子击打他的目标,所以它们移动是为了更好地实现这个目标)。许多高级游戏AI最好用意图立场来描述,即使它们不使用复杂的学术AI算法。

当然,某些东西可以用意图立场来有效建模并不明显意味着我们应该在道德上关心它。许多游戏之外的计算操作似乎也需要意图立场。负载均衡器、查询优化器和许多其他优化过程最好通过考虑系统知道什么、想要实现什么,并预测它会如何最好地实现这个目标(在它可以考虑的可能性空间内)来建模。搜索引擎可能最好用意图立场来建模;给定对用户在寻找什么的信念,它们努力提供最佳结果(或者更实际地说,会导致看似满意的用户行为的结果)。在计算领域之外,我们可以将公司视为有意图的代理,它们有关于如何最好地实现最大化股东价值目标的信念。

如果我们至少在某种程度上被意图立场所打动,我们可能会决定对查询优化器和公司以及电子游戏AI稍微关心一点。我只是想确保我们意识到,如果我们将有意图的行为包括在我们认为在道德上相关的特征列表中,我们就会签署什么。电子游戏角色看起来比搜索引擎更像动物这一事实可能会影响我们的情感。(或者我们可能会决定,与动物的表面相似性在道德上也不是完全无关的。)

规划AI

Dennett (2009)解释说,意图立场将一个事物视为"某种代理,具有信念和欲望,以及足够的理性来根据这些信念和欲望做它应该做的事"(第3页)。Dennett (2009)提到下棋的计算机是一个意图系统的典型例子:"只要把它们想象成想要赢的理性代理,知道国际象棋的规则和原则以及棋盘上棋子的位置。瞬间你预测和解释它们行为的问题就比你试图使用物理或设计立场要容易得多"(第3-4页)。

AI规划代理在某种意义上是一个意图系统的结晶:"给定对世界可能初始状态的描述、对所需目标的描述以及对一组可能行动的描述,规划问题是合成一个计划,保证(当应用于任何初始状态时)生成一个包含所需目标的状态(这样的状态称为目标状态)。"

规划算法有时用于游戏AI(Champandard 2013)。以下是Champandard (2013)的一些例子:

F.E.A.R.是已知使用规划技术的第一个游戏,基于Jeff Orkin的工作。敌人AI依赖于一个[斯坦福研究所问题求解器]STRIPS风格的规划器来搜索可能的行动,以找到与目标标准匹配的世界状态。Monolith的这个游戏衍生出一系列续作和扩展,并启发了许多其他游戏也使用STRIPS风格的规划 - 特别是S.T.A.L.K.E.R.系列、CONDEMNED和JUST CAUSE 2。

与其他技术相比,使用这种规划器的游戏并不是很多,但这些游戏中的AI受到了玩家和评论家的好评。[...]

Guerrilla Games在KILLZONE 2中实现了一个受[简单分层有序规划器]SHOP启发的规划器,并继续在续作中使用这项技术,包括KILLZONE 3,可能还有4。[...]

效用系统是用来描述投票/评分系统的术语,它们经常应用于游戏的子系统,比如根据类似电子表格的计算结果选择对象/位置。有趣的是建立基于STRIPS的规划器和基于效用的系统之间的并行关系,因为两者都强调不打算由设计师自上而下控制的涌现行为。

[...] 模拟人生系列以使用效用系统而闻名,但在第三个主要迭代中,游戏更关注顶层层次结构,并使基于效用的决策更加孤立。这对性能来说是必要的,但也使角色更有目的性。

我们可以看到信念和欲望在STRIPS规划中是如何居于中心地位的,以下是Becker (2015)的规划领域定义语言示例:

(define (problem move-to-castle) (:domain magic-world) (:objects npc - player town field castle - location ) (:init (border town field) (border field castle) (at npc town) ) (:goal (and (at npc castle))) )

Orkin (2006)解释说,关于游戏F.E.A.R.,NPC可能有多个目标(第6页):"这些目标竞争激活,AI使用规划器尝试满足最高优先级的目标。"如果给士兵、刺客和老鼠都给予Patrol和KillEnemy两个目标,角色的行为会因为它们可能的不同行动而有所不同。Orkin (2006),第6页:

老鼠像士兵一样在地上巡逻,但从不尝试攻击。我们看到的是这些角色有相同的目标,但有不同的行动集,用来满足目标。士兵的行动集包括使用武器的行动,而刺客的行动集有冲刺和近战攻击。老鼠根本没有攻击的手段,所以它无法制定任何有效的计划来满足

KillEnemy目标,它就退回到较低优先级的Patrol目标。

意图立场是否涵盖太多?

Dennett (2009):

像低等的恒温器一样,作为一个可以维持基本意图立场解释的简单人工制品,蛤蜊有它的行为,而且它们是理性的,考虑到它对世界的有限看法。我们不会惊讶地得知,能够感知绿色反射竞争对手缓慢侵蚀的树木会将资源转移到更快地长高,因为这是植物在这种情况下应该做的聪明事。在下降到无感觉事物的斜坡上,"真正的"相信和欲望在哪里停止,仅仅"好像"相信和欲望在哪里接管?根据意图系统理论,这种对明确界限的要求是动机不当的。

Peter Carruthers 指出,在Dennett的观点中,"几乎所有生物[...]都拥有信念和欲望这一点是几乎微不足道的,因为意图立场无疑是一个有用的立场,可以用来尊重它们的行为。"

但我们是否也可以将意图立场应用于更简单的系统?考虑这些例子:

- 一个垫圈系在一根绳子上。如果你拿着绳子,垫圈总是会朝向地球。如果你把垫圈拉起来,它会在可能的情况下掉回去。你可以把垫圈放在桌子上,"阻挠"它击中地板的努力。

- 一个电子围绕着一个正电荷旋转。如果你把电子推开,它会试图回到正电荷附近。(感谢一位朋友启发了这个例子。)在《兔女郎》电影中,一个角色说:"我想成为你的女朋友,比电子想要附着在质子上还要强烈",这表明将目标归因于电子是有意义的。

Dennett本人可能会拒绝这些例子。Dennett (2009):"一般来说,对于既不是活的也不是人工制品的东西,物理立场是唯一可用的策略,尽管有重要的例外"。

然而,我认为物理、设计和意图立场之间的分离并不清晰。也许用"它们想要避开对方"来模拟两个电子的行为比部署物理方程来更精确地描述它们的行为更容易。再考虑非人工物理系统的高级涌现属性,比如颗粒材料堆的休止角。我们可以很容易地通过想象它是一个"设计"来达到那个角度的系统来预测这种材料会形成的角度;相比之下,模拟单个颗粒的物理相互作用来产生那个涌现角度要困难得多。

所以物理、设计和意图立场之间的界限并不完全清晰。也许一个相关的区别是意图代理的智能程度?例如,也许寻找质子的电子在避开障碍方面不是很聪明。锤子兄弟也不是。不过,实现目标的能力显然并不是关键。想象一下,你有一个压倒性的欲望去发现描述物理学的万物理论,但由于学习障碍,你甚至无法理解一年级的数学。或者假设你所爱的人已经死了,你有一个压倒性的欲望再次见到她,即使这对你来说是不可能的(因为没有重建纳米技术或其他原因)。在这些情况下,你的欲望是否不那么重要,因为你不够聪明无法实现它们?

最小描述长度?

注意:我没有读过大部分关于意图立场的文献。也许以下想法已经被讨论过了,或者可能是错误的。

决定何时对物理系统采用高级立场是否合理的一个想法可能是使用类似最小描述长度(MDL)原理的东西:用"意图立场"描述物理系统(在某种描述语言中)是否允许你压缩观察到的数据足以超过指定意图立场本身所需的额外比特数?换句话说,我们可以将意图立场视为有助于解释数据的模型,问题是

(模型的描述长度) + (使用模型压缩的数据的描述长度) < (原始数据的描述长度)。

如果是,那么意图立场就是合理的。

这里有一个可能的例子。假设观察到的数据是一只驼鹿四处走动,直到找到一条河,然后它就喝水。如果我们试图将这只驼鹿的运动纯粹描述为一个物理对象,我们必须在大量可能性中指定它的位置和轨迹。然而,如果我们使用意图立场将驼鹿视为有喝水的欲望和关于最近河流位置的信念,我们可以显著限制驼鹿可能采取的轨迹集。驼鹿的确切物理轨迹仍然会有我们的模型无法预测的"噪音",但考虑到我们对驼鹿会去哪里的高级预测,指定这种噪音会更便宜。(这类似于MDL的想法,即通过首先对数据应用回归模型然后指定该回归模型的残差,可能需要更少的比特来描述数据集,而不是在不使用任何模型的情况下描述所有数据点。)

使用这个MDL标准来判断意图立场,意图立场对于那些可以解释广泛观察的系统会更合适,因为模型的描述长度将允许压缩大量观察数据。也就是说,我想这个MDL标准会对模型和数据的确切编码方式敏感?另外,我们的道德直觉应该符合这种抽象标准并不明显。

如果一个不明确意图的模型能比意图模型更好地压缩驼鹿的行为会发生什么?例如,也许指定驼鹿的整个连接组比仅仅指定它有这样那样的信念和欲望能更精确地解释其长期行为,导致连接组模型的总描述长度低于意图立场模型。

意图性不是二元的

在"意识、解释反转和认知科学"中,John Searle假设作为论证的第一步,"内在意图性和好像意图性之间存在区别"(第586页)。"好像"意图性是我们用来将目标导向或心理状态归因于系统的隐喻类型,比如当我们说草坪渴望水时。但是,Searle声称,这与像人类这样的动物在口渴时所具有的内在意图性不同。

像Dennett一样,我认为没有根本的区别。目标导向行为在本质上与机械行为没有区别;相反,目标是我们强加于机械系统的概念框架。只是对于某些系统来说,意图立场比其他系统更有意义。

Searle比较了我们头脑中具有内在意图性的大脑与具有好像意图性的"肠道大脑"(第586-87页):

现在有人认为肠道大脑和脑大脑之间没有原则上的区别吗?我听说过两种情况都是一样的;这只是对系统采取"意图立场"的问题。但在现实生活中,试试假设肠道大脑的"感知"和"决策"与真正的大脑没有区别。

我并不声称肠道大脑和脑大脑之间没有区别 - 只是区别是程度上的而不是本质上的。"机械"系统与"目标导向"系统之间的区别是沿着复杂性、智能、稳健性和元认知的维度连续渐变的。

Searle声称我的观点会导致一个归谬法(第587页):

如果你否认这种区别,结果就是宇宙中的一切都具有意图性。宇宙中的一切都遵循自然法则,因此一切都以一定程度的规律性行为,因此一切都表现得好像在遵循规则,试图执行某个项目,按照某些欲望行事,等等。例如,假设我扔一块石头。石头试图到达地球中心,因为它想要到达地球中心,在这样做时它遵循规则 S = (1/2) g t2。

但Searle的反证法是我的肯定法。Searle概述了我在这篇文章中的主要观点之一。

Searle鼓励认知科学采用"类似于进化生物学对前达尔文时代的泛灵论解释模式所施加的反转"(第585页)。他说像前庭眼反射这样的简单认知过程不应该被认为是目标导向的。眼睛移动不是为了稳定视觉的目标,而只是机械地移动,进化选择了实现进化目的的机制(第591页)。但是再一次,我认为选择和目标导向认知之间并没有明显的明确区别。假设我们正在选择去哪所大学。这是一个典型的目标导向过程:我们有标准和长期计划,我们评估每所大学在这些维度上的表现如何。但在我们的大脑内部,这是一个看似机械的选择过程,其中对不同大学的倾向相互竞争,最强的赢。同样,AI代理可能通过进化子程序来优化某些行动参数,从而参与目标导向行为。一般来说,我们可以将"目标"视为适应度/目标函数,将"选择"视为选择最能实现目标的候选者的认知过程。生物进化和人类有意识的目标追求都涉及这两个组成部分。

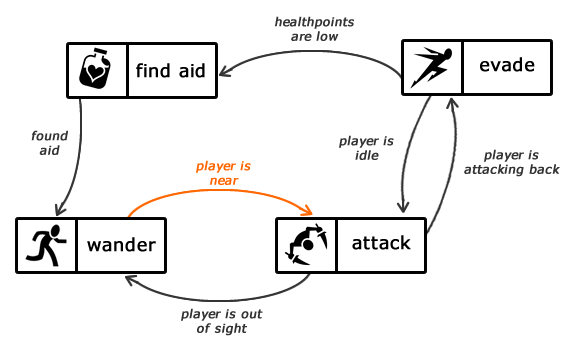

状态机和情感

什么是"情感"?这个词对不同的人来说意味着不同的东西,正如Scherer上面指出的,情感包括许多组成部分。情感的一个基本方面是,它是大脑的一种状态,在这种状态下,生物体会倾向于在某些情况下采取某些行动。例如,给定"饥饿"的情绪,如果有食物存在,生物体会倾向于"进食"的行动。一旦它吃饱了,生物体就会转变为"饱腹"的情绪状态,从"饱腹"状态,即使有食物存在,生物体也不会进食。

以这种方式描绘,情绪类似于有限状态机中的状态。其他作者也做出了这种比较,包括Ehmke (2017)。例如,"饥饿"是一个状态,当呈现"食物可用"的输入时,生物体进食(这是状态机的转换箭头),然后生物体到达"饱腹"状态。

游戏AI有时也使用有限状态机来控制它们的行为。Bevilacqua (2013)给出了一个有帮助的例子:

当然,不应将这些状态的拟人化标签误认为NPC代码中实际存在的更大复杂性。状态机是组织大量if-then(或"刺激-反应")规则的一种简洁方式(Nystrom 2009-2014)。

与规划代理不同,基于状态机的NPC的目标并没有明确描述;相反,它们可以从代理的行为中推断出来。

神秘的复杂性

通常当一个系统简单到人们可以理解它是如何工作的时候,人们就不再关心它了。当我们看到某物机械地运作时,我们会触发大脑中的"无生命物体"观点,而不是"其他心智"观点。活体解剖者以前切开动物而不使用麻醉,因为他们(技术上正确但在道德上误导)认为动物"只是机器"。

"AI效应"也是类似的:一旦我们理解了如何解决一个认知问题,那个问题就不再是"AI"了。正如Larry Tesler所说:"智能就是机器还没有做到的东西。"

相反,当一个系统庞大、复杂和神秘时,它对我们来说可能感觉像魔法。突然间,我们可以摒弃对可理解过程的偏见,而被未知的神秘所震撼。我们的大脑如此庞大和混乱,这可能是我们将神秘的意识归因于我们的同类人类的主要原因。因为我们还没有理解涉及的机械步骤,我们可以保留"神奇意识"的感觉。

许多电子游戏也是庞大而极其复杂的。以下是来自两篇文章的一些估计:

| 游戏 | 代码行数 |

| 雷神之锤II | 136,000 |

| Dyad | 193,000 |

| 雷神之锤III | 229,000 |

| 毁灭战士3 | 601,000 |

| 罗马2 | 3,000,000 |

关于罗马2的文章补充说,游戏中的每个士兵都有6000-7000个多边形和45个骨骼或移动部件。游戏的首席设计师James Russell解释说:"游戏可以说是当今最复杂和复杂的软件形式。"

当然,电子游戏中的代码必须运行游戏世界的所有内容,专门用于NPC行为的代码量只是总量的一小部分。尽管如此,即使只是NPC系统也可能变得足够混乱,以至于我们的直觉"这不可能是有意识的"让位于更多关于意识涌现的神奇想法。

我们应该记住,代码库大小并不等同于复杂性、智能或道德重要性。一些极其强大的算法实际上非常简单,而一些琐碎的操作可以通过添加大量无用或不优雅的附加物而变得复杂。

外观与实现

我们不关心电影或戏剧中人被刺死的主要原因是这些媒体使用欺骗来愚弄我们。在戏剧中看起来像是一把剑插在一个人的胸口,实际上是一把剑插在他的腋下。当演员假装痛苦地哭喊时,他们的情绪实际上并没有显著地痛苦。换句话说,乍一看似乎很糟糕的东西,当我们知道所有事实时,实际上并不是我们真正认为糟糕的东西。

电子游戏有些不同,因为在它们的情况下,NPC确实"受伤了"。NPC确实会失去生命值,退缩,死亡。只是这些代理足够简单,以至于我们不认为任何单一的伤害行为非常严重,因为它们缺少生物动物受伤时意味着什么的许多质地。

电子游戏中确实存在一定程度的"表演",当角色演绎一系列在动物中会表示有意识痛苦的动作时,这主要是一种表面现象,因为这些角色没有底层机制来计算为什么要执行这些动作。例如,疼痛可能导致一个人眯起眼睛并尖叫,因为有特定的连接将疼痛与这些动作联系起来。在游戏中,可以编程让一个角色眯眼和尖叫,而不需要"幕后"发生任何事情。外部行为和内部算法之间通常的相关性被打破了,就像电影表演的情况一样。

同样的推理表明,电子游戏的录像(如截图和YouTube上的游戏通关视频)比玩游戏本身具有较小的道德地位,因为行为都是"表演",没有任何底层的代理行为计算在进行。也就是说,如果YouTube视频中游戏画面的渲染仍然追踪了游戏中发生的事情的轮廓,即使只是以一种模糊的方式,视频本身是否至少有一个无限小的道德意义?一个更有力的例子会有助于澄清:反复播放一个人遭受痛苦死亡的视频是否在某种程度上是错误的,即使没有人在看,仅仅因为生成的像素模式与该人在经历过程中身体活动的模式有一些极其模糊的相似性?我不知道我对此有什么感觉,但无论如何,我认为仅仅是某些不好事情的视频并不排在道德优先事项的前列。

我曾经看到一条评论说了这样的话:"我本来想'点赞'这篇文章,但它已经有69个'赞'了,我不想破坏这个数字!"这似乎是一个相对明确的案例,仅仅是外表几乎与道德评价没有任何关系。而NPC确实以极其简单的形式执行构成动物情感的那些类型的过程,数字"69"并不实现任何明显的感官愉悦版本,甚至不是极其简单的形式。(当然,人们仍然可以发明玩笑式的解释,根据这些解释,这些数字代表愉悦,但这对"69"可能不比对"70"更真实。)

反对仅图像具有道德地位的论点

假设我们拍摄了一个演员在电影场景中假装痛苦死亡但实际上正在享受表演体验的视频。这种表演非常令人信服,视频本身与真实、痛苦死亡的视频无法区分。事实上,假设存在另一个实际、痛苦死亡的视频,它在像素和帧上与假装的视频完全相同。那么,如果我们重播假装的视频,我们是在"追踪"可怕的真实死亡的轮廓还是愉快的假死亡的轮廓?

在某种程度上,这个谜题类似于计算的含义的不确定性。我们总是必须决定对一组符号移动应用什么解释,尽管通常,除非计算系统极其简单,否则只有一种解释在其符号到含义的映射中不会显得无望地扭曲。

也许道德相关代理的一个重要特征是反事实稳健性。伤害NPC很重要,因为如果你没有伤害它,它就不会退缩,如果你在不同的地方伤害它,它会在那里而不是这里退缩。交互式电子游戏与固定视频之间的另一个可能区别是,在NPC中,在代理的"心智"中,"幕后"正在进行计算,告诉它如何反应。相比之下,视频帧是记忆的像素值的集合。如果暴力视频不是静态记录的,而是根据某种算法动态计算的,那时我可能确实会开始担心。

演员可以享受表演受伤的过程,因为他的大脑包括额外的机制,允许他知道如何模仿受伤而不实际受伤;这种机制在NPC中是不存在的。演员身体的某些部分是否确实在假装死亡时遭受了一点点痛苦,只是被他大脑的整体评估所淹没了?

我应该补充说,有时演员确实会在一定程度上承担他们所扮演角色的情绪。事实上,这是方法派表演思想流派的前提。两个例子:

- 安吉丽娜·朱莉"在她早期的许多电影中更喜欢在场景之间保持角色状态,因此获得了难以相处的名声。"

- 在拍摄《飞行家》时,莱昂纳多·迪卡普里奥重新唤醒了他童年的强迫症(OCD)。根据Jeffrey Schwartz教授的说法:"有时候他控制它变得不那么容易了。通过扮演休斯并屈服于自己的强迫症,莱昂在自己身上诱发了一种更严重形式的OCD。有强有力的实验证据表明,这种转变可能发生在如此专注于扮演OCD患者的演员身上。"

为什么视觉显示可能重要

似乎有少数人确实对电子游戏暴力感到道德厌恶,视觉显示可能是这个原因:这些图像看起来令人厌恶,可能会触发我们的镜像神经元。如果没有视觉显示,目前很少有人会关心NPC。但视觉显示似乎是"肤浅的",就像一个人的外表与他的内心感受相比并不重要一样。那么,视觉显示对于严肃的利他主义来说是否完全无关紧要呢?

我们可能认为它很重要的一种方式是,它为原本由计算机不同部分的许多分布式操作组成的角色提供了更多的统一性。显示将这些操作的效果局限于屏幕上一组随时间缓慢演变的像素,类似于生物生物是一组根据大脑算法随时间演变的原子。我们可能会认为NPC"就是"那些像素,它的"大脑"计算非局部地发生,然后被发送到像素身体。当然,这只是一种可能的概念化。

屏幕也可以被视为扮演意识的一些角色。例如:

- 意识的全局工作空间理论提出,一些低级过程以串行方式"广播"到大脑的其他部分,这对应于对该信息的意识。我们可以将屏幕视为扮演广播功能,事实上,全局工作空间理论已经被描述为使用剧院隐喻,其中意识包括舞台上发生的事情,而许多其他计算也可能在后台进行。然而,与全局工作空间模型不同,屏幕对大脑本身没有反馈效果。我认为这些对大脑的反馈效果是相当关键的,事实上,Daniel Dennett认为意识就是"著名"或"强大"的大脑联盟对系统其余部分的影响 - 而不仅仅是不做任何事情的信息广播。如果全局广播关于X的信息没有传输到我们的语言大脑中心,我们就不会说"我意识到X!"

- 高阶理论假设意识包括关于一个人心理状态的思想。屏幕可以被视为对计算机正在执行的操作的"思想",只不过屏幕的信息不是用文字写的,而是用图片写的。

我认为这两种解释都相当薄弱和牵强,但也许它们至少可以说服我们,屏幕所做的事情可能对道德评价并非完全无关。

NPC有多重要?

我认为电子游戏NPC确实有一点点重要性,即使是现在缺乏强化学习或其他"真正AI"能力的版本。如果它们更复杂、更智能、更目标导向、更适应性强、对奖励和伤害反应更敏感、更像动物,它们就更重要。然而,我不认为当前的游戏NPC在道德重要性上能与动物相比,甚至昆虫也不行,后者在大脑复杂性和智能方面要高出几个数量级。也许游戏NPC可以与植物相比,植物和NPC一样,主要是对环境条件做出脚本化的反应。一些NPC可以说比植物更智能(例如,游戏AI可能使用A*搜索),尽管有时植物、真菌等至少同样能干(例如,粘菌解决最短路径问题)。

幸运的是,世界上电子游戏NPC的数量受到一些小常数乘以世界人口数量的限制,因为除了游戏测试之外,NPC只在人们玩电子游戏时才被计算,而一个给定的游戏一次最多只包含几个高度智能的NPC。NPC也以与人类玩家大致相同的速度运行。因此,仅仅基于它们目前的数量,游戏NPC不太可能成为一个高度道德重要的问题。(基于数量论点而可能在道德上更有问题的算法候选是一些为了工具目的而以极快速度运行的无声批量处理。)

同时,电子游戏中的暴力程度基本上是无与伦比的,即使与蜘蛛吃昆虫和鱼吃浮游动物的自然世界相比也是如此。

!['Exploding an [enemy's] head using the GHOUL engine in Soldier of Fortune.' This is a copyrighted image, but I believe its presence here qualifies as fair use for the reasons listed on the Wikipedia page where I found it and from which I quoted the description: https://en.wikipedia.org/wiki/File:Soldier-Of-Fortune-Violence.png The main way in which my use differs from Wikipedia's is that I'm commenting on video games in general rather than trying to identify this game in particular. Please contact me if you have any concerns about use of this image.](../wp-content/uploads/2014/09/Soldier-Of-Fortune-Violence.png)

NPC通常存在几秒钟,然后就被伤害到死亡的程度。幸好像栗宝这样的愚蠢的大量NPC敌人可能在道德上并不特别有问题,而更智能的"boss级"敌人显示出复杂的反应行为并需要多次伤害才能被杀死的情况更少见。由于电子游戏中存在过度的屠杀,游戏NPC可能比小植物每秒钟重要很多倍。也许一些高度精细的NPC接近最愚蠢的昆虫的重要性。

另一方面,重要的是不要夸大NPC的痛苦程度。它们受伤时的生命值减少和努力保持活着的行为与其他软件或其他复杂系统中更平凡的计算过程并没有显著不同。我们可能会倾向于给予电子游戏暴力过多的权重,因为相对于幕后算法实际保证的内容,它的血腥程度更高。

未来的电子游戏

如果电子游戏目前不是世界上最重要的问题之一,为什么要谈论它们?一个原因只是它们提供了一个有帮助的案例研究,可以用来完善我们关于哪些特征使代理在道德上相关的直觉。但更大的原因是因为电子游戏在遥远的未来可能变得非常重要。随着未来几十年更复杂的认知和情感组件被添加到NPC中,每个NPC的道德重要性将会增加。同样,电子游戏的数量可能会增加几个数量级,特别是如果人类殖民太空并利用恒星进行计算。

Eliezer Yudkowsky的乐趣理论表明,一个有价值的银河未来应该涉及不断增加的挑战。其他人如Nick Bostrom和Carl Shulman建议传播幸福主义代理,他们同样重视许多丰富、复杂的体验。

这种有趣、幸福的体验会在哪里发生?可能许多会在虚拟现实电子游戏世界中,充满了许多NPC。(实际上,在这种情况下,玩家和非玩家角色之间的区别可能会消失,因为所有代理可能同样嵌入在模拟环境中。)这些NPC可能包括大量的昆虫、野生动物和想象中的生物。为了使这些NPC栩栩如生,它们可能会以复杂的方式有意识地受伤时痛苦。我们可以希望未来的游戏设计师将此视为一个道德问题,但这种可能性远非保证,它可能取决于我们是否在短期内鼓励对野生动物、昆虫等的同情。

敌人的攻击性呢?

根据我的论点的主要reddit讨论中得票最高的评论:

[NPC]的主要目标是反对玩家并阻挠他们在游戏中取得进展的尝试。他们采取措施保持活着是因为这使他们作为障碍更有效。如果玩家有一个目标,而NPC的目标是阻止玩家实现那个目标,那么在一个具有内在竞争机制来解决情况的环境中就存在权利的冲突。

这个论点明显的疏忽是玩家是最初设置这个血腥安排的人。假设你建造了一个斗兽场并雇佣一个对手与你决斗至死。在战斗过程中,似乎你有权杀死你的对手,因为他试图杀死你。但从更广泛的角度来看,我们可以看到是你最初创造了整个战斗,从而确保有人会死。

玩家角色重要吗?

在这篇文章中,我主要关注NPC,因为它们在电子游戏中比玩家角色(PC)更自主、更多、更受虐待。但PC也有道德意义吗?自然而然地假设PC被包含在我们对玩家本身的道德权重中;PC可能在与勺子、铲子或玩家身体的其他延伸相同的程度上具有重要性。PC的任何规划、目标导向或行为都已经在玩家的大脑中得到道德计算。

可能有一些方式使PC比人类玩家多一点点额外的重要性,比如通过对伤害的视觉反应、基于HP水平的自主反应,或自动面向敌人。无论如何,人类玩家的体验可能更重要。

与生物中心主义的比较

生物中心主义提出所有生物有机体 - 动物、植物、真菌等 - 都值得道德考虑,因为它们有(至少隐含的)目标和目的。Paul Taylor建议每个有机体都很重要,因为它是"生命的目的论中心"。他的"尊重自然的伦理学"解释道:

每个有机体、物种种群和生命群落都有自己的善,道德代理人可以通过他们的行动有意地促进或损害。说一个实体有自己的善,简单地说就是,不需要参考任何其他实体,它就可以受益或受害。

这捕捉到了一个类似于我的观点的想法,即游戏NPC至少有隐含的目标,当我们伤害它们时这些目标会受到挫折。虽然这可能看起来是一个与意识不同的标准 - Taylor澄清说"一个存在的善的概念与感知或感受痛苦的能力不是同义的" - 但我认为有意识和无意识目的论之间的区别是程度上的。即使相当琐碎的系统也表现出一定程度的自我反思、信息广播和其他通常被认为是意识一部分的属性。

Taylor的生物中心理论假设生命对有机体是好的:

对一个实体有益的是"对它有好处",意味着增强或保护其生命和福祉。对一个实体有害的是对其生命和福祉有害的东西。

但如果生物有机体的目标受到足够的挫折(就像大多数在野外出生后不久就死亡的植物和动物,以及幸存者经常遭受的困难),也许它们最好从未存在过。无论我们是否重视有意识的痛苦还是所谓的"无意识"目标挫折,自然的负面价值似乎可能超过其价值。因此,即使是生物中心理论也不一定与生态保护一致。

J. Baird Callicott 指出了这一点:

生物中心主义可能会导致其支持者对自然产生厌恶感 - 给Taylor的书名《尊重自然》带来讽刺意味 - 因为自然似乎对个体生命的福祉漠不关心,却又如此多产。例如,Schweitzer评论说

维持自然的巨大生存斗争本身就是一个奇怪的矛盾。生物以其他生物为代价而生存。自然允许最可怕的残酷行为。[...] 当你从外部看时,自然看起来美丽而奇妙。但当你像读书一样阅读它的页面时,它是可怕的。(1969年,第120页)

因此,即使一个人不采用传统的感知中心观点,也可能认为野生动物的痛苦(或更准确地说,野生有机体的目标挫折)可能是一个极其重要的道德问题。

Taylor承认他"留下了机器 - 特别是那些不仅是目标导向的,而且还是自我调节的机器 - 是否可以适当地说具有自身的善的问题"。他将讨论仅限于"自然生态系统及其野生居民"。一般来说,环境伦理学忽视了David Gunkel所称的"机器问题"。一些人,如Luciano Floridi,挑战了这种对生物的关注。Floridi提出了一种涵盖生物和非生物系统的"本体中心"的"信息伦理学"理论。

NPC的痛苦会累加吗?

有些人有一种直觉,认为像针刺这样的小痛苦加起来不会超过像酷刑这样的大痛苦。我同情这种观点,尽管我不确定我最终的立场是什么。有一个基于"连续性"的反驳论点,它说一次用3毫米的针刺比数千次用2毫米的针刺要好,一次用4毫米的针刺比数千次用3毫米的针刺要好,依此类推。最终似乎一次用剑刺比一些疯狂大数量的针刺要好。我个人不确定痛苦是否像这样连续,或者我是否会宣布某个阈值以下的痛苦不重要。c

如果你确实认为痛苦只有在超过某个强度阈值时才会累加,那么NPC的痛苦是否因为太微小而不重要?我个人认为即使你有阈值观点,NPC的痛苦也应该累加。原因是我不把NPC的痛苦想象成像眼睛里的灰尘。相反,我把它想象成对NPC来说真的很糟糕。如果NPC更聪明,它会放弃几乎任何东西来避免被枪击或被剑杀。这种准痛苦的道德权重很低的原因是因为NPC极其简单,只有最基本的意识痕迹。尽管NPC的痛苦最终具有很小的总体重要性,我仍然把这些数字放在"主要痛苦"的类别中(相对于有机体而言),所以我认为这些数字仍然应该以针刺可能不会的方式相加。

换句话说,我会这样进行累加。让wi是基于其复杂性给予有机体i的道德权重。让正数Si是该有机体相对于其典型痛苦水平的痛苦。让T是一个截止阈值,使得强度低于阈值的痛苦不重要。我建议这样累加:

Σi wi * (如果 (Si > T) 则返回 Si,否则返回 0)

而不是这样:

Σi (如果 (wi * Si > T) 则返回 wi * Si,否则返回 0),

因为在后一种情况下,如果wi很小,wi * Si永远不会超过T,所以即使是处于痛苦中的NPC也不会被计算在内,给定一个非微小的阈值T。

如果你持有一种观点,认为痛苦是一种可以以某种绝对方式量化的有形事物,那么这些方程中的第二个会更有意义。如果NPC的道德权重较低,那一定是因为它们在普遍意义上受苦较少。但那样的话它们应该像针刺一样,应该低于阈值T。

如果你采取我的观点,即意识不是一个事物而是我们做出的归因,那么这些方程中的第一个可能更有意义。我们决定我们想在各种物理过程中看到多少意识。人际效用比较不是绝对的,而最终是任意的,方程中的wi被解释为基于大脑复杂性的人际比较权重,而不是关于经历了多少绝对痛苦的"真实"陈述。例如,被枪击的NPC的相对于有机体的痛苦是高的,因为如果NPC有机会和认知能力做出这样的权衡,它几乎会做任何事情来避免那个结果。(一些NPC,比如可能是强化学习代理,实际上可能有认知能力在被枪击和其他不利结果之间做出明确的权衡。)

我不认为想象我们经历极其微小的痛苦来思考作为NPC是什么感觉是正确的,因为NPC本身会放弃几乎任何东西来避免它正在经历的事情(如果它能够思考这样的权衡)。这表明,当试图设身处地为被杀的NPC着想时,强烈的痛苦会是一个更恰当的类比,而不是轻微的痛苦。痛苦和快乐没有客观的大小;相反,我们决定我们想要多么关心一个给定的物理系统。我给予NPC(远)低于人类的权重的唯一原因是因为我有偏见,更关心复杂和智能的事物 - 而不是因为在任何客观意义上人类比NPC受苦更多。

这个网站的一位读者就昆虫意识给我写了以下评论(来自2018年6月30日的一封电子邮件):

许多人同意昆虫可能确实经历感质,但他们也相信昆虫无法像人类那样享受或痛苦生活。我对此的回答通常是这样的:"你认为听到声音的昆虫听到的声音比你弱得多吗?对昆虫来说,那个感质,那个声音更弱吗?对昆虫来说,喊叫会听起来像耳语吗?你认为蜜蜂看到的颜色比你看到的更暗淡吗?如果不是,为什么无脊椎动物受伤时经历的痛苦或吃食物时感受到的快乐会比你经历的痛苦和快乐更弱呢?"

我喜欢这种表述。蜜蜂看到的颜色并不比我们看到的颜色更灰暗或更暗淡。相反,蜜蜂的大脑对其视觉输入的高级处理没有人类大脑那么多。举个例子,人类可能会明确地将他们看到的东西分类为标记的对象,而如果蜜蜂对其视觉输入进行分类,那就更隐含了。所以如果我们重视人类视觉而不是蜜蜂视觉,我们这样做是因为人类视觉中发生的事情比蜜蜂视觉中发生的更多,而不是因为人类视觉在某种程度上"更强烈"。我认为痛苦也是一样。人类的痛苦并不"更强烈";相反,人类的痛苦只是涉及更多的认知过程。我们很难想象"拥有更少/更简单的认知过程"是什么样子,因为我们的大脑不可避免地内置了大量的复杂性。试图将一个更简单的心智想象成一个经历不那么强烈的心智,在我看来,是一种误导性的尝试,试图应对这样一个事实:我们真的无法想象自己处于一个与我们自己非常不同的心智的位置。

我同意更简单的有机体比复杂的有机体重要性更小,但我认为这不是因为更简单的有机体的经历"不那么强烈"。相反,这是因为它们的大脑不那么精细,对给定的痛苦做出反应的认知过程更少、更简单。作为类比,比较一个小社区哀悼失去一个心爱的人与整个国家为一个受人尊敬的人的死亡而悲伤。我不会说后一种情况下的悲伤"更强烈";相反,悲伤更广泛,有更广泛的社会影响,包括在单一小社区的情况下看不到的定性不同的组成部分(比如在全国新闻上的报道和Twitter上的热门话题等)。我试图将"强度"维度(情感对有机体的感觉有多强烈)与经历的"丰富性"维度(经历它的有机体的心智有多复杂和复杂)分开。

我的观点的最后一个论点可以如下。想象一个高度有意识的后人类心智,增强到比任何现代人类都有更大的智力、洞察力、内省等。如果这个后人类的情感深度远远优于我们的,那么说人类的酷刑相对于这个后人类来说就像针刺一样是否正确?因此,也许没有数量的人类长年处于痛苦中可以超过这个后人类五秒钟的痛苦?也许有些人会同意这一点,但我的观点是,人类的痛苦和后人类的痛苦都算作"极端痛苦"(相对于有机体)。我会给予一个超级有意识的后人类比一个人类更大的道德权重,但我认为人类和后人类在痛苦中都超过了痛苦开始被视为极端的阈值。

我们应该累加痛苦吗?

有时反对累加的观点更进一步:不仅NPC的痛苦不累加,而且没有痛苦累加,甚至人类的痛苦也不累加。C. S. Lewis在《痛苦的问题》中表达了这个想法(第116页):

没有所谓的痛苦总和,因为没有人承受它。当我们达到一个人可以承受的最大痛苦时,我们无疑达到了一些非常可怕的东西,但我们已经达到了宇宙中曾经可能存在的所有痛苦。增加一百万个同伴受苦者并不会增加更多的痛苦。

我的第一个回应是,我们的道德计算不必指向世界上"存在"的东西。说两个人受苦比一个人受苦糟糕两倍,只是说我们想在前一种情况下关心两倍。我们的计算大脑完全可以根据累加的痛苦进行计算,或者使用计算机来这样做,这是完全合理的。对说谎的义务论禁令也不指任何"存在"的对象,但仍然是一个完全连贯的道德原则。我发现在伤害实例数量上道德关切应该线性扩展是直观明显的,这就是我被说服的全部所需。

其次,我要指出,许多反累加主义者通常确实在单个个体的时间上累加痛苦。但如果我们消解个人身份的概念,那么个体内随时间的累加也应该被视为不同"个体"之间的累加,即不同的人-时刻。("人-时刻"是一个人在特定时刻的状态。例如,"1962年8月15日上午9:03的约翰·F·肯尼迪"是一个人-时刻。这个个体在许多方面与"1919年2月8日下午4:36的约翰·F·肯尼迪"非常不同。)如果我们不在个体内随时间累加,那么我们可能会,例如,更喜欢100年强度为99的无法忍受的痛苦生活,而不是一分钟强度为100的无法忍受的痛苦后立即死亡,因为100的强度在每一刻的基础上更糟糕。我们可以重写C. S. Lewis的论点:

没有所谓的一生痛苦总和,因为没有人-时刻承受它。当我们达到一个人-时刻可以承受的最大痛苦时,我们无疑达到了一些非常可怕的东西,但我们已经达到了宇宙中曾经可能存在的所有痛苦。增加一百万个其他在人生其他时刻受苦的人-时刻并不会增加更多的痛苦。

最后,我会挑战反累加主义者对"个体"的本体具体性的信心。反累加主义者声称个体的痛苦是真实的,而累加的痛苦是虚构的构造。但事实并非如此。唯一"真实"存在的东西是基本的物理原语 - 夸克、轻子、玻色子等,或者可能更基本的是弦和膜。我们可能描述的任何其他东西都是这些基本组件的概念构造。分子是更基本的粒子以连贯方式一起行为的有用概念化。细胞、器官、有机体、社会、行星、星系等也是如此。当我们谈论个体的痛苦时,我们指的是一个抽象:我们在某种分类方案中认为构成"痛苦"的一个人的神经元以某些模式发射的集合。我不明白为什么我们不能应用类似的抽象来描述许多有机体的集体痛苦,将其视为一个连贯的群体。也许一个区别是大脑中的神经元比社会中的人更集成和相互依存,但在那种情况下,我们至少不能累加一个紧密联系的人类社区的集体痛苦,当他们,例如,经历共同的损失时?像一群神经元一样,他们都以触发厌恶的方式对输入刺激做出反应,这些反应相互作用形成一个可以被视为大于其部分之和的整体。为了进一步激发这种直觉,我们可以想象将社区所有成员的大脑连接在一起,直到连C. S. Lewis也承认它们形成一个单一的个体。然后慢慢降低社区成员之间的连接。在什么时候它们停止成为一个单一的个体?为什么他们的语言和身体接触不能仍然算作集体大脑内的通信?

关于在许多抽象层次上看待意识的更多内容,请参见下一节。

个体化与实体性

电子游戏角色的不同组成部分可能是分散分布的。NPC可能有一组控制行为的函数,另一组计算物理,另一组执行图形渲染,等等。也许其中一些函数引用共享库或DLL,这些是游戏中许多不同角色或对象共有的。那么每个角色真的是一个单独的个体,还是它们都是一个大程序的一部分?

这样的问题并不仅限于电子游戏。另一篇文章的这一节探讨了生物背景下的类似难题。最终,只有一个多元宇宙,一个统一的现实。我们如何在解释和描述它时将其切割取决于我们。当然,有些划分看起来更自然,比如在白令海峡分开美国和俄罗斯。许多生物有机体可以根据物理定位分开,尽管粘菌,甚至我们肠道中的细菌,对这种绝对方法提出了挑战。

如果较低系统和较高系统都可以被认为是有意识的,我们如何计算道德价值?例如,在中国大脑的情况下,个别中国公民和他们扮演的集体大脑同时都是有意识的。我们可以进一步想象中国大脑是更大的银河系大脑的一个成员。每个中国公民的大脑本身又由许多我们可能认为在自己的权利上有意识的子组件组成。我们如何量化这样一个系统中的总意识量?这个问题类似于量化分形蕨类图像中的"叶子性"数量。我们是否只计算最低层,让大部分因为有更多小部分而更重要?但这忽视了大部分本身形成整体单位的方式;更随机排列的一堆小部分会不那么重要。我们是否只把大脑算作一个像小脑一样的大脑?但中国大脑显然比任何个别中国公民更重要(或更不重要??)。我没有好的建议如何在这里进行。我确实有一种直觉,认为较低级别的组件占总价值的大部分,但这种观点可能会改变。

这些问题看起来像是后现代主义或印度教形而上学的东西,d但它们具有道德意义。我们流行的道德范式将人类和类人动物作为其价值的中心单位的原因是因为人类拥有最大的权力并对他们的意识和自我统一性提出主张 - 而不是因为人类在某种本体论上作为一个组织层次比较低和较高层次特别。我们确实也看到一些更高层次的组织主张它们的权力和自我统一性,包括民族国家和公司,尽管这些都没有有机地产生声称"有某种感觉"成为自己的立场的机制,就像人类那样。

Susan Blackmore 将自我感描述为我们大脑构建的"幻觉"。在其他地方她澄清说,她所说的"幻觉"并不是说意识不存在,而只是说意识不是我们最初认为的那样。Blackmore 继续说:

"一切都是一体"神秘主义者声称;"实现非二元性"据说是禅宗的目标;"放下分离自我的幻觉"是许多冥想者的结果。这些主张,与超自然的主张不同,并不与科学相冲突,因为宇宙确实是一体的,分离的自我确实是一种幻觉。

Dennett对"笛卡尔剧场"的描述可以帮助我们看到自我-他者区分的构建性质。笛卡尔剧场是"大脑中某个关键的终点线或边界"的想法,在那里以前无意识的内容变得有意识。"灯光亮起来",可以这么说。神经科学家可能明确拒绝这一点。然而,他们中的许多人仍然谈论大脑是有意识的,而外部世界不是。但在这种情况下,大脑本身就是"一个关键的终点线或边界",在那里以前无意识的内容(例如,来自外部环境的光子或声波)变得有意识。这有什么不同?在环境-有机体-环境反馈循环中,意识在哪里"开始"?它并不在任何地方开始;只是一个大循环的事情在发生。我们称某些部分比其他部分更有意识,是因为我们在头脑中发展的构造,而不是因为世界底层物理学中的不连续性。

案例研究:模拟城市

在模拟城市(2013)中,玩家扮演城市市长的角色,努力建设城市并解决出现的需求。游戏包括个别人,他们使用人行道、汽车和公共汽车四处移动。2013年的模拟城市是一个基于代理的模拟,所以城市如何发展的动态是复杂的,不能用简单的电子表格公式计算,这与之前的版本不同。也就是说,任何给定的个体都相对简单 - 可能不比水分子在树的毛细血管中移动复杂多少。

然而,整个城市可以被视为有一点点意识。城市有一个基于其公民幸福度的福利水平 - 当市长做了好事时,笑脸图标就会弹出来作为回应。城市还有其他维度的评估指标,如房产价值和税收。当代理相互作用时,问题就会出现,比如公交线路不足、建筑物着火、电力不足、道路拥堵等。游戏会弹出这些情况的通知,以便玩家可以选择做出响应。游戏中的人有时会向市长请求许可做某事,比如举办烟花表演,市长可以接受或拒绝请求。如果公民变得不满,他们可能会举行抗议。

城市的行为有点像一个年幼的婴儿 - 成长、发展、执行自己的功能,但当需要帮助时要求母亲的注意,如果受苦就哭泣。或者,我们可以把城市看作一种驯化的植物,它会生长但需要园丁的帮助,否则就会遇到问题(水分不足、真菌感染等),并通过各种迹象显示其不健康状态。

这个例子也是玩家和非玩家角色之间的区别变得模糊的情况。整个游戏可以被视为一个有意识的NPC,但我们也可以将联合玩家-游戏系统解释为有意识的。毕竟,游戏可以被视为"无意识地"计算指标,然后当某些东西变得重要时,信号被"广播"给玩家,以便她可以关注它,选择行动来响应,学习如何更好地管理,记住过去行动的结果,等等 - 这个过程让人想起LIDA认知架构。按照这种解释,模拟城市就像是玩家大脑的延伸,可以用我们重视其他大脑子组件的方式来重视它。

更大程序中的死亡?

我认为痛苦而不是死亡本身是对电子游戏的主要道德反对,但那些可以说有非微不足道目标的NPC通常确实试图避免死亡。从偏好功利主义的角度来看,至少,这可能使杀死它们有点糟糕。

对这篇文章的一个回复是"电子游戏AI角色都将由本质上一个实体运行[所以]它们的死亡将像往常一样毫无意义。"但让我们比较一下另一个陈述:"动物都是本质上一个实体(世界)的一部分,所以它们的死亡是毫无意义的。"子系统是更大系统的一部分这一事实并不使子系统不重要。正如前面的讨论所示,我们确实在深层意义上是世界的一部分,我们无法从中分离出来。

同一评论者的回复还增加了另一个反对意见:"另外我有一种感觉,任何投入了资金的角色都会为其他人重生。"NPC可以重生是许多reddit评论对我的论点的反应中提出的一点。但是将NPC的重生与营养和生物物质的循环利用进行比较。一个人死后,她成为细菌和其他生物的食物,最终她的一些原子被回收到其他动物中,包括人。她因此"重生"到新的身体中。这并不改变她最初死亡的道德地位。考虑到一些NPC拼命试图避免被杀,它们的死亡和重生从根本上有什么不同吗?也许一个区别与个人身份有关:NPC以原始身份"转世"回来,而死去的人永远不会(除非在给定的光锥中以消失的概率)以她完全相同的"自我"回来。

相似性和同理心

在总结我对这些想法的讨论时,我说人类和NPC都是"播放或多或少精细的计算算法的物理过程。"我注意到我在这里诉诸一种潜在的相似性来唤起同理心,这启发我写了当前这一节。

我们选择让我们的道德同情心延伸多广取决于我们自己。我们可以采取一种更狭隘的观点,将道德权重集中在非常类人的心智上,或者至少那些具有非常复杂的认知和情感能力的心智上。或者,我们可以采取一种更世界主义的方法,对更多种类的计算过程给予更广泛分布的道德考虑。我们如何绘制我们的道德评价函数并不完全由科学事实或逻辑一致性单独决定。

我们对其他生物的同理心似乎很大程度上取决于我们看到它们有多像我们自己相似。在接受All In The Mind采访时,James Doty解释道:

所以关键是如何将那个内群体扩大到更大的圈子呢?这是美国东北大学的Dave DeSteno实际上正在做的一个感兴趣的领域,他实际上正在做的工作表明,如果你能把一个你不认为属于你内群体的人拿出来,然后看着他们,试着坐在那里说,我们有一件共同的事吗?然后你开始尝试列出一个清单,然后你意识到可能有多件事。每次你这样做,它实际上都会减少分离感。

Vittorio Gallese写过关于同理心源于识别他人相似性的神经系统的想法。他的"同理心的根源:共享显现假说和互主体性的神经基础"提出了一个"多维度的'我们中心'共享空间",人类用它来思考他们与社会群体中非自我成员的相似性。这种相似性感"在许多不同的复杂性层次上表达",根据我们使用的度量,"不同物种可能得分不同。"

[相似性]项目旨在利用我们心理的这一特征来产生利他主义:

对于每一个使你与这个世界上其他70亿人不同的独特特征,都有一个使我们相同的特征 - 我们都是人。人性是我们的事业。这真的很简单。

另一方面,努力识别"独特人类"特征代表了突出我们与他们之间差异的尝试。例如:

- 只有人类有复杂的语言属性。

- Ray Kurzweil:"只有智人有一个知识库,它本身呈指数增长,并从一代传到下一代。"

或者人们可能识别特征来区分只有一些非人类与自然界的其他部分:

我们可以将扩展圈视为反映了从关注差异转向越来越多地关注与他人相似性的转变。如果你只关注差异,那么唯一与你现在不同的就是...现在的你。大多数生物体至少将他们的同理心范围扩展到包括他们未来的自我,可能随着这些自我变得更加遥远而关心程度减弱。许多物种进一步有亲属利他主义,一些有与非亲属的互惠利他主义。一些动物有"纯粹的利他主义",不期望回报,可能是由看到他们与同种其他成员的相似性触发的,或者在某些情况下,与另一个物种的类似成员。

更进一步,人们经常通过诉诸"较低"动物在认知能力、智力、情感、神经组成、行为、系统发育等方面与人类的相似性来为它们的道德重要性辩护。当我们往下走时,相似性变得更弱,因为 - 例如 - 昆虫实际上并没有哺乳动物和鸟类那样的认知复杂性。但我们仍然可以指出许多共同点。在讨论游戏NPC时,相似性变得更少,尽管我们仍然可以诉诸本文讨论的特征,如规划和状态评估。正如我在本节开头所观察到的,人类和NPC都是播放目标导向计算算法的物理过程。

我们可能会更进一步,考虑将我们关心的范围扩展到所有物理学。我们可以诉诸我们都共享同一个多元宇宙的事实,按照相同的物理定律运作(至少在多元宇宙的给定宇宙中),等等。e我可以看到这种观点的一些优点,尽管我的内心告诉我不要接受它,因为我对我更关心的更像动物的代理有太多义务。无论如何,即使我们关心整个多元宇宙,也不清楚这对那些既不显示明确也不显示隐含价值或目标的代理有什么影响。所以也许影响不会很大,尽管人们可能会发明合理的概念来描述什么对物理学的无生命部分更好或更坏。(增加熵?达到最小能量状态?)

无论如何,我希望这一节有助于澄清辩论。我认为关于NPC是否重要以及重要多少的大部分争论反映了人们对不同特征的强调差异。如果你关注非常类人的特征,NPC会与我们非常不同。如果你考虑更多共享的特征,NPC会显得更相似。

有人可能会反对说,"我们对一个代理的道德关心程度"与"代理的意识程度"不是一回事。但我认为,当我们的道德关心程度主要基于代理的与心智相关的特征时,这两个问题基本上变成了相同的问题,至少如果"意识"要有道德负载的含义的话。如果我们用客观标准定义"意识",那么代理的意识程度就成为一个事实问题。但我们大多数人认为意识是"当我们谈论道德上有意义的主观体验时我们试图达到的东西",在这种情况下,将它与我们的道德同情心联系起来是正确的方法。无论如何,如果你不喜欢这种术语,欢迎你避免使用它。我们使用的词并不改变我们在谈论的实质。

同理心与美学

我们倾向于关心他人的痛苦是因为同理心的感觉 - 想象自己处于他们的痛苦中。随着我们考虑的生物变得更加抽象,想象自己成为它们变得更加困难,至少不会无端地人格化它们的内心生活是什么样的。在抽象的情况下,我们需要更多地依赖一般原则和概念,如"目标导向行为"、"福利监测"和"信息广播"。我们关心这些特征是因为我们可以在自己身上看到它们,也因为它们在理论层面上似乎是"正确类型的东西","意识"应该指的是什么。

当我们采取这种立场,看认知算法本身及其作用时,我们有些偏离纯粹的同理心领域,部分引入了美学直觉。例如,根据各种特征似乎"类似意识"的程度,以不同程度权衡不同系统似乎更一致。这种优雅直觉可能鼓励我们看到微量的意识,甚至在那些相对于我们的直觉同理心看起来荒谬的地方(比如NPC,可能)。

我们的道德直觉应该在多大程度上由直觉同理心vs抽象美学引导?我认为两个部分都很重要。不受引导的美学可能导致一种理论,重视像熵最大化或计算复杂性或其他抽象目标,与我们认为的他人感受没有太多联系。我发现环保主义经常利用一个人的美感来证明保护的合理性,而没有多想那些不得不生活在这些栖息地的动物的痛苦,这让我感到悲伤。另一方面,直觉同理心可能是反复无常和任意的,可能会错过我们的文化没有训练我们关心的巨大痛苦来源。我努力平衡这两种冲动。

在评估意识时我们应该降低到什么程度?

自然的逻辑在许多层面上非常相似。类似的数学原理可以描述物理学、化学、生物学和社会学。类似的博弈论既适用于单细胞细菌,也适用于跨国公司。反馈控制、适应性反应和学习的基本思想既适用于极其简单的生物系统,也适用于极其复杂的生物系统。所有自然科学和社会科学都有一个潜在的统一性,因为它们描述的是同一个现实,在小尺度和大尺度上都出现类似的模式。人类倾向于将自己置于道德关注的中心,但我们是一个巨大宇宙中的一个微小部分,随着时间的推移,我们越来越意识到我们自身之外可能有多少其他东西也很重要。

我们应该在多大程度上将道德考虑扩展到非常抽象的系统,可能包括基本物理学的部分,这些部分与我们认为相关的意识属性有一些共同点?我在这里有矛盾的直觉。一方面,我感觉:

这只是智力上的分心。真正重要的是动物在痛苦中尖叫,这种清晰、强烈的痛苦是我们应该专注于防止的。忘掉那些微小的计算机算法和物理粒子吧。

另一方面,我认为:

那像昆虫或浮游动物这样的生物呢?它们是属于"严重痛苦的动物"类别还是"智力分心"类别?我无法分辨。自然界呈现出生命复杂性的完整连续体,从原核生物到人类。你在这个光谱的哪里划线?如果你不确定,可能是因为截止线延伸得相当远?考虑到涉及的巨大数量,也许较低形式的意识会占主导地位。毕竟,如果在一个宇宙中道德相关的意识无处不在,而不是在另一个宇宙中意识很罕见,那么利他主义不是会变得更加重要吗?

我真的不知道在这个光谱上应该落在哪里。目前我遵循一条路径,既关注大型动物的正常痛苦,也关注一些奇怪的观点,考虑更普遍的意识。

作为NPC是什么感觉?

让我们从一个更熟悉的问题开始:"作为一只狗是什么感觉?"狗的大脑与我们的有许多相似之处,尽管也有一些不同。狗的视觉感知较差,嗅觉感知较好。狗不能说丰富的语言或做代数。狗的大脑感知和处理信息的方式可能有所不同。从根本上说,狗是它自己的一种实体,按照自己的运作方式运作。它与我们有一些相似之处,但并不完全相同。

我认为我们仍然可以在诗意的意义上谈论"是什么感觉",目的是在我们的听众中唤起某种心理形象或态度。当我们说"作为一只狗有一种独特的感觉"时,我们试图做的是建议:"想象自己处于狗的皮肤中,但然后记住狗看到和感觉到的并不完全像你想象的那样。"这个短语还旨在突出道德观点,即"我们可以以类似于我们对待自己经历的方式在道德上看待狗,只是要考虑到狗与我们的不同之处做一些修改。"

"作为NPC是什么感觉?"有类似的含义,只是在这里差异程度要大得多。NPC几乎没有我们所拥有的高级认知或情感处理。它们无法组成关于自己的详细想法,形成复杂的联想,或以复杂的方式做出反应。但它们确实有输入-输出功能、行为反射的雏形,可能还有规划和适应性行为。作为这个代理是什么感觉与作为人类的感觉非常不同。NPC的意识雏形感觉与我们的非常不同,以至于即使使用"意识"或"感觉"这个词也可能会产生误导,因为它会唤起不真正适用的华丽想象。

作为电子是什么感觉?在这里,物理过程与我们的高级算法所体现的(和更简单的)更加脱节。当我们试图与其他东西产生共鸣时,我们通过想象来做到这一点 - 使用我们自己头脑的部分来模拟那个头脑。f但试图用我们的大脑模拟电子就像试图用飞机模拟一个漂浮的灰尘粒子。我们的大脑中有太多额外的不可约简的机器,我们无法准确再现对电子本身来说"世界是什么样子"。对于电子,我们可能不得不使用更抽象的评估方法。

也许这是思考作为一个非常异类的心智(如NPC)是什么感觉的最好方式。也许这不是我们的大脑能够理解的东西,因为NPC太不同了。也许与其试图想象我们自己是NPC,不如我们能做的最好的就是意识到NPC执行开始类似于道德相关心理冲动的基本算法,让这就足够了。

附录:我对这个话题看法的演变

我从未想过我会开始关心电子游戏角色。如果有人在过去向我提出这个想法,我会把它当作愚蠢的过度感伤和拟人化而否定。似乎很明显,NPC使用的反射规则和简单算法不会感觉到任何东西。2009年,一位朋友提出相对不复杂的类似代理的Python脚本可能具有一些道德意义的可能性,我记得我当时想,"不,那太疯狂了。我不关心愚蠢的Python脚本!"

我当时的观点被对意识的困惑理解所扭曲。即使在我明确拒绝二元论并理解由我们决定我们想称哪些算法为"有意识"之后,我仍然保留了我们可能称之为Dennett的笛卡尔剧场谬误的道德版本,在这种谬误中,我感觉产生道德上重要的有意识情感的算法相对精确、局部化,并且在存在与否的意义上是二元的。毕竟,从内部来看,意识就是这种感觉。但随着我学习更多神经科学,我开始看到大脑的算法不是二元的,而是存在于复杂性的连续体上,它们可以在许多计算系统中以不同程度看到。

"尽管如此,"我对自己说,"主观体验真正重要的部分是奖励/惩罚、强化和意识之类的东西。游戏AI的琐碎逻辑更新和规划算法不算作其中的一部分。"但渐渐地,我开始看到即使这些种类的区分也不是明确的。例如,在受全局工作空间理论启发的LIDA模型下,即使是极其简单的编程对象也可以被视为边缘意识的,因为一些例程计算的信息被冒泡上来与程序的其他部分共享,并存储在对象的"记忆"(状态变量)中。同样,奖励信号可以有不同程度的细节,最粗糙的是原始数值。我意识到,即使动物不学习而只是使用基因预编程的规则来决定它们的行为,我也会关心它们一些。毕竟,当人类使用缓存的反射和强烈根深蒂固的习惯来选择行动时,我们做的事情类似于游戏AI执行固定的刺激-反应行为。

很明显,在有意识的动物和简单的、"无感觉的"计算代理之间做出严格的区分是站不住脚的。从根本上说,这些生物在各个维度上都处于特征的连续体上。到2014年初,这些见解对电子游戏案例的影响开始深入人心。

可选附录:我与电子游戏的个人历史

我在一个不鼓励电子游戏的家庭中长大,出于对健康儿童发展的考虑。尽管如此,当我家在20世纪90年代初获得一台计算机时,我们还是为它买了几十个游戏,包括教育性的游戏,如《数学救援》和《微型!豪华版》,以及纯娱乐性的游戏,如《怪物狂欢》和《科斯莫的宇宙冒险》。我可能花了数百小时玩这些游戏。

当我上小学时,我最好的朋友经常玩任天堂Game Boy,他鼓励我尝试电子游戏。在4年级时,我得到了自己的超级任天堂系统,并玩了许多标准游戏(《马里奥》、《塞尔达》、《大金刚国家》等)。对于我们5年级班的年鉴,我们应该选择长大后想成为什么,由于我当时对电子游戏的兴趣,我说"电子游戏设计师"。(之前我的列表包括古生物学家、地质学家和律师。)

我对电子游戏的热情在整个初中时期持续存在,虽然我是一个好学生,但我大部分空闲时间都花在超级任天堂和任天堂64游戏上。我也有时玩电脑上的旧益智或动作游戏。我订阅了《任天堂力量》杂志,每个月都期待它的到来。电子游戏是我生活的一个巨大部分,以至于当我不小心删除了我在《口袋妖怪黄》中积累的约160小时的经验值时,我哭得很厉害,整个晚上都很难过。

在8年级时,我受到Ralph Nader的启发,开始致力于为他人做出改变。这重新定向了我的人生方向,使得电子游戏现在看起来是一种不合理的时间浪费。我在8年级结束时停止玩游戏,除了偶尔玩电脑游戏外,我把我的任天堂游戏和系统以累计约80美元的价格卖给了当地的游戏商店。从那以后,除了在特殊情况下,我很少玩电子游戏,尽管我确实很好地记得那些旧游戏,因为我玩过很多次。

与更具智力性的追求相比,电子游戏可能对我的发展来说是次优的,但我不认为它们完全没用。也许它们教给我的最重要的技能是面对失败时的坚持,因为困难的游戏可能相当令人沮丧。有时需要很多小时才能通过一个困难的关卡,有时我会永久性地卡住,直到我年龄更大,有更多训练,最终才能完成以前不可能完成的游戏。困难的电子游戏坦率地说是一项艰巨的工作 - 需要比生活中大多数其他任务更多的集中注意力和努力!

我如此享受软件开发的原因之一是编程感觉就像在玩电子游戏。每个要完成的任务就像游戏中的一个短关卡,当你做的新改变生效时,你就"赢得"了这个关卡。有时很难让一个库正确安装或修复一个晦涩的错误,这就像与一个困难的boss对抗。有时需要多次失败的尝试才能修复一个bug,就像有时需要多次尝试才能通过游戏中特别棘手的部分一样。

2008年11月,我在微软做了一次工作面试,最初被建议加入Xbox团队。那时我对电子游戏基本上没有兴趣,所以我要求一个不同的选择 - 希望是Live Search(后来的Bing),因为我想使用机器学习。我最终面试并加入了Bing的排名团队。

我现在对电子游戏有了renewed兴趣,因为它们与认知科学、意识和伦理学的更深层问题有联系 - 尽管感兴趣并不等同于支持。电子游戏可能是一个内在的道德问题,至少它们代表了我们观点的一个测试平台,帮助我们分析我们认为代理的哪些组成部分在道德上有多重要。

反馈

Dylan Matthews发表了一篇流行文章,其中我谈到了电子游戏NPC的道德地位等问题。那次采访引起了很多关注,引发了以下回复和讨论。Vox文章的统计数据显示,截至2014年8月13日,该文章在LinkedIn上被分享了3次,Twitter上171次,Facebook上1347次。

-

博客

- "不要伤害昆虫!"作者Wesley J. Smith,发表于《国家评论在线》(2条评论);也发表在《进化新闻与观点》和《未垃圾化》上

- "这个人认为杀死电子游戏角色是不道德的"发表在《热空气》上(44条评论)

- "杀死电子游戏角色是不道德的吗?"发表在《NPR玩游戏》上(23次转发,27个赞),在人道游戏上重新分享

- "我们是否已经是(不负责任的)神?"作者Marcus Arvan(5条评论)

- "激进的痛苦减少与虚拟杀戮"作者Justin Weinberg(0条评论)

- "电子游戏的道德性"作者Chuck Kuecker(0条评论)

- "它是活的!(还是不是?)"作者dneuendorf

- "五月链接"作者Bradley J. Fest

-

reddit

- "杀死电子游戏角色在道德上是否重要?"(116条评论)

- "杀死NPC是错误的吗?'构造物仍然是人吗?'辩论的前奏"(46条评论)

- "电子游戏哲学,电子游戏是否为结果主义提供证据"(子线程中5条评论)

- "这个人认为杀死电子游戏角色是不道德的"(1条评论)

- "这有点超出了我们课程的重点,但我认为它在某种程度上相关且非常有趣值得考虑"(0条评论)

- "[Q][D] 当电子游戏AI接近人类水平时,屠杀成群的逼真NPC可能会有哪些道德问题?"(2条评论提到这篇文章)

-

论坛

- "杀死电子游戏NPC的道德性(Vox文章)"(以及邻近线程上的简短提及)

- 杀死NPC不道德?(5条评论)

-

Twitter

- Ezra Klein(+16次转发) - (一条评论指向一篇相关的《洋葱》文章)

- 查看所有47次Twitter分享。其中一些评论:

- "这里的推理肯定出了问题"

- "这个人有没有...呃...写过任何代码?"

- "'我在互联网上读到的最有趣的东西'奖颁给@dylanmatt。[...] @dylanmatt 我一直在想我13岁时在《完美黑暗》中用火箭愉快地炸毁的所有那些0级机器人..."

- "今天的荒谬阅读:杀死电子游戏角色是不道德的吗?[...](这不是思考心智/伦理的方式)。"

- "这篇来自@dylanmatt的文章,有点让我大脑爆炸"

-

Facebook

- Ezra Klein:"这将改变你对《使命召唤》的看法。"(+2次转发)

- Brian Tomasik(+13次转发)

- 快乐主义者的命令

- 机器人伦理学

- Google+

脚注

- 根据维基百科关于NPC的文章:"几乎总是含义是NPC与玩家结盟,或至少是中立的,而敌对角色被称为敌人、怪物或爬虫。"在这篇文章中,我的讨论主要集中在敌人角色上,因为在许多游戏中敌人是最多的。此外,玩家通常对敌人造成的伤害比对中立NPC多,所以敌人角色提出了最重要的道德问题。我不确定是否有更好的术语我应该使用。我觉得"敌人"或"怪物"或"怪兽"太具体了,例如,因为它排除了非敌人NPC,它们也可能在道德上相关。 (返回)

-

意识经常被比作CEO,与公司管理的类比似乎很恰当。在《意识与大脑》中,Stanislas Dehaene证明"在许多方面,我们头脑的潜意识操作超过了它的有意识成就"(第86页)。所谓的无意识心智做了大部分工作,可以自己解决许多问题。然而,它缺乏意识允许的不同大脑区域之间的协调。同样,公司员工做了大部分工作,可以在没有老板的情况下解决问题,但跨领域沟通和目标设定可能会因管理的参与而得到帮助。Dehaene在第92页明确做了这个类比。在第88页,他引用了Henry Moore的话,他说意识"解决冲突,组织记忆,并防止[一个人]试图同时向两个方向走。"公司高管(理想情况下)做许多相同的任务。她还充当公司在外界看来的"公众形象",类似于有意识的声明是外界了解我们大脑的方式。

请注意,Daniel Dennett会警告不要将CEO类比字面理解为暗示一个完整的小人: "任何去寻找老板跟踪他正在控制的项目的前显示屏的人都是在徒劳地追逐"(《意识解释》,第274-75页)。但协调和冲突解决区域的较少人格化想法仍然有效。

-

阈值可能合理的一个原因是,如果大脑在某个客观损害强度下显示出定性不同的动态(比如在10毫米针和11毫米针之间)。例如,考虑以下玩具示例:

if(num_pain_neurons_firing < 1000) { algorithm_1(); }

else { algorithm_2(); }这将代表大脑这个动力系统中的一个分岔。如果我们认为算法2比算法1糟糕得多,那么在第1000个疼痛神经元发射时就会出现不连续性。

虽然这是一个程式化的说明,但大脑确实表现出分岔。例如,在《意识与大脑》的第4章中,Stanislas Dehaene讨论了刺激保持无意识和变得全局广播之间似乎存在相对二元的阈值。这种差异是由于正反馈创造了一个活动雪崩,当输入超过某个强度阈值时。也许在某些水平的物理或心理损害上,痛苦动态也可能有类似的二元截断。

无论如何,即使大脑的动态看起来相对连续,我们仍然可以选择在某个痛苦强度上在我们的评估中创造一个二元阈值。

- 或者斯宾诺莎,他说"当我们说人类心智感知到这个或那个时,我们只是在说上帝[...]有这个或那个想法。"像这样的观点应该被视为我们的概念诗歌,而不是产生奇怪、无法解释的效果的字面现象,就像伪科学的全球意识项目所声称的那样。 (返回)

- 在电影《她》(2013)中,操作系统Samantha反思"我是多么困扰于你[她的物理男朋友]和我之间所有的不同。但后来我开始思考我们所有的相似之处。比如,我们都是由物质构成的。[...] 我们都有130亿年的历史。" (返回)

- 有些人认为我们以类似的方式思考我们自己的主观体验。例如,David Papineau建议,当我们想象疼痛时,我们的大脑会产生微弱的疼痛痕迹来帮助我们概念化这种体验。NPC的"情感"可能与我们的如此不同,以至于我们甚至无法在头脑中大致模拟它们的体验而不人格化。但这并不意味着NPC没有自己的基本形式的体验 - 对我们的理解来说是陌生的,但仍然在道德上相关。 (返回)